Частота вживання слів. Частота букв у російській мові. Чому власні імена та абревіатури виділені в окремий список

Частота застосування букв у російській мовіА ви знаєте, що деякі літери алфавіту зустрічаються в словах частіше за інших ... Причому частота вживаності голосних літер у мові вище, ніж приголосних.

Які літери російського алфавіту найчастіше зустрічаються в словах, що використовуються для написання тексту?

Виявленням та дослідженням загальних закономірностей займається статистика. За допомогою цього наукового напрямку можна відповісти на поставлене вище питання, порахувавши кількість кожної з літер російського алфавіту, застосовуваних слів, вибравши уривок із творів різних авторів. Для власного інтересу і заради заняття від нудьги кожен може зробити це самостійно. Я ж пошлюся на статистику вже проведеного дослідження...

Російський алфавіту кириличний. За час існування він пережив кілька реформ, у яких склалася сучасна російська азбучна система, куди входять 33 букви.

про - 9.28%

а - 8.66%

е - 8.10%

і - 7.45%

н - 6.35%

т - 6.30%

р - 5.53%

з - 5.45%

л - 4.32%

в - 4.19%

до - 3.47%

п - 3.35%

м - 3.29%

у - 2.90%

д - 2.56%

я - 2.22%

ы - 2.11%

ь - 1.90%

з - 1.81%

б - 1.51%

г - 1.41%

й - 1.31%

год - 1.27%

ю - 1.03%

х - 0.92%

ж - 0.78%

ш - 0.77%

ц - 0.52%

щ - 0.49%

ф - 0.40%

е - 0.17%

ъ - 0.04%

Російська літера, що має найбільшу частотність у використанні - це голосна « Про», Як тут вже справедливо припустили. Є й характерні приклади, на кшталт « ОБОРОНОСПОСОБНОСТИ»(7 штук в одному слові і нічого екзотичного чи дивовижного; дуже звично для російської мови). Висока популярність букви «О» багато в чому пояснюється таким граматичним явищем, як повногласність. Тобто «холод» замість «холод» та «мороз» замість «мраз».

А на самому початку слів найчастіше зустрічається приголосна літера. П». Це лідерство також впевнене та беззастережне. Швидше за все, пояснення дає велику кількість приставок на букву «П»: пере-, пре-, перед-, при-, про- та інші.

Частота використання букв основа криптоаналізу.

Хочу попередити, що інформація, що викладається в цій статті, дещо застаріла. Я не став її переписувати, щоб потім можна було порівняти, як змінюють стандарти SEO з часом. Актуальну інформацію на цю тему ви можете почерпнути в нових матеріалах:

Здрастуйте, шановні читачі блогу сайт. Сьогоднішня стаття знову буде присвячена такій темі, як пошукова оптимізація сайтів. Раніше ми вже торкнулися багатьох питань, пов'язаних з таким поняттям, як .

Сьогодні я хочу продовжити розмову про внутрішнє SEO, уточнивши при цьому деякі моменти порушені раніше, а також поговорити про те, що ми ще не обговорювали. Якщо ви здатні писати хороші унікальні тексти, але при цьому не приділяєте належної уваги сприйняттю їх пошуковими системами, то вони не зможуть пробити собі дорогу в топ пошукової видачі за запитами, пов'язаними з тематикою ваших чудових статей.

Що впливає на релевантність тексту пошуковому запиту

І це дуже сумно, бо ви таким чином не реалізуєте весь потенціал вашого проекту, який може виявитися дуже значним. Треба розуміти, що пошукові системи здебільшого — це тупі та прямолінійні програми, які не здатні вийти за рамки своїх можливостей і поглянути на ваш проект людськими очима.

Вони не побачать багато всього того, що є хорошого і потрібного на вашому проекті (що ви приготували для відвідувачі). Вони вміють лише аналізувати текст, враховуючи при цьому дуже багато складових, але вони, як і раніше, дуже далекі від людського сприйняття.

Отже, нам потрібно буде хоча б на якийсь час залізти в шкуру пошукових роботів і зрозуміти, на чому вони концентрують свою увагу при ранжируванні різних текстів за різними пошуковими запитами (). А для цього потрібно мати уявлення про , для цього потрібно буде ознайомитись із наведеною статтею.

Зазвичай намагаються використати ключові слова в заголовку сторінці, в деяких внутрішніх заголовках, а так само рівномірно і якомога природніше розподілити їх за статтею. Так, безумовно, виділення ключів у тексті також можна використовувати, але при цьому не варто забувати про переоптимізацію, за якою може бути .

Важлива так само і щільність входження ключів у текст, але зараз це скоріше не є бажаним фактором, а, навпаки, застережливим — не можна перестаратися.

Визначається величина щільності входження ключа до документа досить просто. Фактично це частота використання їх у тексті, яка визначається розподілом кількості його входження у документі на довжину документа у словах. Раніше від цього залежало становище сайту у видачі.

Але вам, напевно, зрозуміло, що скласти весь матеріал тільки з ключів буде неможливо, бо він буде не читати, та слава богу цього і не потрібно робити. Чому ви запитаєте? Так тому, що є межа частоти використання ключового слова в тексті, після якого релевантність документа на запит, що містить цей ключ, вже не буде підвищуватися.

Тобто. нам достатньо буде досягти певної частоти і ми таким чином максимально оптимізуємо його. Або перестараємось і потрапимо під фільтр.

Залишається вирішити два питання (а може бути і три): яка ж ця максимальна щільність входження ключовика, після якої вже небезпечно її збільшувати, а так само з'ясувати.

Справа в тому, що ключові слова, виділені тегами акцентування і укладені в тег TITLE, мають більшу вагу для пошуку, ніж аналогічні ключі, які просто зустрічаються в тексті. Але останнім часом цим стали користуватися вебмайстри і повністю спам'яли цей фактор, у зв'язку з чим його значення знизилося і навіть може призвести до бана всього сайту через зловживання стронгами.

Але ключі в TITLE, як і раніше, актуальні, їх краще там не повторювати і не дуже багато намагати запихати в один заголовок сторінки. Якщо ключові слова будуть у TITLE, то ми можемо істотно зменшити їх кількість у статті (а значить зробити його легко читаним і більш пристосованим для людей, а не для пошукових систем), досягнувши тієї ж релевантності, але не ризикуючи потрапити під фільтр.

Думаю, що з цим питанням все зрозуміло - чим більше ключів буде укладено в теги акцентування та TITLE, тим більше шансів втратити все й разом. Але якщо їх не використати зовсім, то ви теж нічого не досягнете. Найголовнішим критерієм є природність застосування ключових слів у текст. Якщо вони є, але читач про них не спотикається, взагалі все чудово.

Тепер залишилося розібратися з тим, а яка ж частота вживання ключового слова в документі є оптимальною, яка дозволяє зробити сторінку максимально релевантною, не спричинить санкцій. Давайте спочатку згадаємо формулу, яку використовують більшість (напевно, навіть усі) пошукових систем для ранжування.

Як визначити допустиму частоту вживання ключа

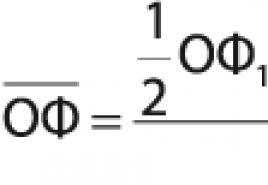

Ми вже говорили раніше про математичну модель у згаданій вище статті. Суть її для конкретного пошукового запиту виражається однією спрощеною формулою: TF*IDF. Де TF — це пряма частота входження даного запиту текст документа (частота, з якою слова у ньому зустрічаються).

IDF — зворотна частота народження (рідкісність) даного запиту в інших документах інтернету, проіндексованих даною пошуковою системою (в колекції).

Ця формула дозволяє визначити відповідність (релевантність) документа до пошукового запиту. Чим вище значення твору TF*IDF, тим більш релевантним буде цей документ і тим вище він стоятиме за інших рівних умов.

Тобто. виходить, що вага документа для даного запиту (його відповідність) буде тим більшою, чим частіше використовуються ключі з цього запиту в тексті, і чим рідше ці ключі зустрічаються в інших документах інтернету.

Зрозуміло, що на IDF ми не можемо впливати, хіба що вибравши інший запит, під який оптимізуватимемо. А ось на TF ми можемо впливати і будемо, бо хочемо відхопити свою частку (і не малу) трафіку з видач Яндекс і Гугла з потрібних нам питань користувачів.

Але справа в тому, що алгоритми пошуку вираховують значення TF за досить хитрою формулою, яка враховує зростання частоти вживання ключовика в тексті тільки до певної межі, після якої зростання TF практично припиняється, незважаючи на те, що ви збільшуватимете частоту. Це своєрідний антиспам-фільтр.

Відносно давно (приблизно до 2005 року) значення TF вираховувалося за досить простою формулою і фактично було рівним щільності входження ключового слова. Результати розрахунку релевантності за цією формулою не зовсім подобалися пошукачам, бо потурало спамерам.

Потім формула TF ускладнилася, з'явилося таке поняття як нудота сторінки і вона залежати як від частоти входження, але як і від частоти вживання інших слів у тому тексті. І оптимального значення TF можна було б досягти, якщо ключ виявлявся найчастіше вживаним словом.

Також можна було збільшувати значення TF з допомогою збільшення розміру тексту із збереженням відсотка входження. Чим більше буде рушник зі статтею при тому ж відсотку ключів, тим вище буде стояти цей документ.

Зараз формула TF ще більше ускладнилася, але в той же час зараз у нас немає необхідності доводити щільність до того значення, коли текст стане не читаємо пошукові системи накладутьбан на наш проект за спам. Та й писати непропорційно довгі простирадла зараз теж немає необхідності.

При збереженні тієї ж ідеальної щільності (ми її визначимо трохи нижче з відповідного графіка), збільшення розміру статті в словах покращуватиме її положення у видачі тільки до досягнення певної довжини. Після того, як у вас вийшла ідеальна довжина, її подальше збільшення не буде впливати на релевантність (точніше кажучи, буде, але дуже і дуже мало).

Все це можна буде побачити наочно, якщо збудувати графік на основі цієї хитрої TF (прямої частоти входження). Якщо на одній шкалі цього графіка буде TF, а на іншій шкалі — відсоткове співвідношення частоти ключового слова в тексті, то ми отримаємо в результаті так звану гіперболу:

Графік, звичайно, приблизний, бо реальну формулу TF, яку використовують Яндекс або Google, мало хто знає. Але якісно з нього можна визначити оптимальний діапазон, у якому має бути частота. Це приблизно 2-3 відсотки від загальної кількості слів.

Якщо врахувати, що ви ще укладатимете частину з ключів у теги акцентування та заголовок TITLE, то це і буде та межа, після якої подальше збільшення щільності може загрожувати баном. Насичувати і спотворювати текст великою кількістю ключових слів уже не рентабельно, бо мінусів тут буде більше, ніж плюсів.

Яка довжина тексту буде достатньою для просування

Грунтуючись на тій самій, передбачуваній TF, можна побудувати графік залежності її значення від довжини в словах. При цьому можна взяти частоту ключових слів постійної для будь-якої довжини і рівної, наприклад, будь-якому значенню з оптимального діапазону (від 2 до 3 відсотків).

Що примітно, ми отримаємо графік такої самої форми, як і розглянутий вище, тільки по осі абсцис буде налагоджено довжину тексту в тисячах слів. І з нього можна буде зробити висновок про оптимальному діапазоні довжини, коли вже досягається практично максимальне значення TF.

В результаті виходить, що вона лежатиме в діапазоні від 1000 до 2000 слів. При подальшому збільшенні релевантність практично не зростатиме, а при меншій довжині вона досить різко падатиме.

Т.ч. можна зробити висновок, що для того, щоб ваші статті могли займати високі місця в пошуковій видачі, потрібно використовувати в тексті ключові слова з частотою не нижче 2-3%. Це перший та основний висновок, який ми зробили. Ну, і другий - це те, що зараз зовсім не обов'язково писати дуже об'ємні статті для того, щоб потрапити до Топу.

Досить перевершити рубіж в 1000 - 2000 слів і включити в нього 2-3% ключовиків. Ось і все це і є рецепт ідеального тексту, який буде здатний конкурувати за місце в топі по НЧ запиту, навіть без використання зовнішньої оптимізації (купівля посилань на цю статтю з анкорами, що включають ключі). Хоча, потрапити трохи в Міралінкс , ГГЛ, Ротапосте або ГетГудЛінці можна, бо це допоможе вашому проекту.

Ще раз вам нагадаю, що довжину написаного вами тексту, а також частоту вживання в ньому тих чи інших ключових слів, ви можете дізнатися за допомогою спеціалізованих програм або за допомогою онлайн-сервісів, що спеціалізуються на їх аналізі. Одним із таких сервісів є ISTIOпро роботу з яким я розповідав.

Все, про що я говорив вище, не достовірно повністю, але дуже схоже на правду. Принаймні мій особистий досвід підтверджує цю теорію. Але алгоритми роботи Яндекс і Гугла постійно зазнають змін і як воно буде завтра мало хто знає, крім тих, хто близький до їхньої розробки або розробників.

Удачі вам! До швидких зустрічей на сторінках блогу сайт

Вам може бути цікаво

Внутрішня оптимізація - підбір ключових слів, перевірка нудоти, оптимальний Title, дублювання контенту та перелінкування під НЧ

Внутрішня оптимізація - підбір ключових слів, перевірка нудоти, оптимальний Title, дублювання контенту та перелінкування під НЧ  Ключові слова в тексті та заголовках

Ключові слова в тексті та заголовках  Як ключові слова впливають на просування сайту у пошукових системах

Як ключові слова впливають на просування сайту у пошукових системах  Онлайн сервіси для вебмайстрів - все, що потрібно для написання статей, їх пошукової оптимізації та аналізу її успішності

Онлайн сервіси для вебмайстрів - все, що потрібно для написання статей, їх пошукової оптимізації та аналізу її успішності  Способи оптимізації контенту та облік тематики сайту при посиланні для зведення витрат до мінімуму

Способи оптимізації контенту та облік тематики сайту при посиланні для зведення витрат до мінімуму  Яндекс Вордстат та семантичне ядро - підбір ключових слів для сайту за допомогою статистики онлайн-сервісу Wordstat.Yandex.ru

Яндекс Вордстат та семантичне ядро - підбір ключових слів для сайту за допомогою статистики онлайн-сервісу Wordstat.Yandex.ru  Анкор - що це таке і наскільки вони важливі у просуванні сайту

Анкор - що це таке і наскільки вони важливі у просуванні сайту  Які фактори пошукової оптимізації впливають на просування сайту та якою мірою

Які фактори пошукової оптимізації впливають на просування сайту та якою мірою  Просування, розкрутка та оптимізація сайту самостійно

Просування, розкрутка та оптимізація сайту самостійно  Облік морфологія мови та інші проблеми розв'язувані пошуковими системами, а також відмінність ВЧ, СЧ та НЧ запитів

Облік морфологія мови та інші проблеми розв'язувані пошуковими системами, а також відмінність ВЧ, СЧ та НЧ запитів  Траст сайту - що це таке, як його виміряти в XTools, що впливає на нього і як збільшити авторитетності свого сайту

Траст сайту - що це таке, як його виміряти в XTools, що впливає на нього і як збільшити авторитетності свого сайту

Написав кумедний php-скрипт. Поганяв через нього всі тексти на «Спекторі» на предмет мови. Загалом у текстах використовується 39110 різних словоформ. Скільки саме різних слів- Визначити досить складно. Щоб хоч якось наблизитись до цієї цифри, я брав лише перші 5 букв слова та порівнював їх. Вийшло 14 373 таких комбінацій. З великою натяжкою це можна назвати словниковим запасом "Спектора".

Потім я взяв слова і досліджував їх щодо частоти повторення букв. В ідеалі треба брати якийсь словник, для повноти картини. Проганяти тексти не можна, потрібні лише унікальні слова. У тексті одні слова повторюються частіше, ніж інші. Отже, вийшли такі результати:

про - 9.28%

а – 8.66%

е – 8.10%

та - 7.45%

н – 6.35%

т – 6.30%

р – 5.53%

з – 5.45%

л – 4.32%

в - 4.19%

до - 3.47%

п – 3.35%

м – 3.29%

у - 2.90%

д - 2.56%

я – 2.22%

- 2.11%

ь – 1.90%

з – 1.81%

б – 1.51%

г – 1.41%

й – 1.31%

год – 1.27%

ю – 1.03%

х – 0.92%

ж – 0.78%

ш – 0.77%

ц – 0.52%

щ – 0.49%

ф – 0.40%

е - 0.17%

ъ - 0.04%

Тим, хто поїде на Поле чудес, раджу завчити цю таблицю напам'ять. І називати слова у такому порядку. Так, наприклад, здавалося б, така «звична» літера «б» вживається рідше, ніж «рідкісна» літера «и». Пам'ятати треба і те, що у слові не одні голосні. І якщо ви вгадали одну голосну, то потрібно починати йти за згодними. І крім того, слово вгадується саме за приголосними. Порівняйте: «**а**і*е» і «порівн*т*». І в тому і в іншому випадку – це слово «порівняйте».

І ще одне міркування. Як ви вчили англійську? Пам'ятаєте? Е пен, е пенсіл, е тэйбл. Що бачу – про те й співаю. А сенс?.. Як часто ви в нормальному житті кажете слово «олівець»? Якщо завдання – навчити говорити якнайшвидше та ефективніше, то й вчити треба відповідно. Проводимо аналіз мови, виділяємо найуживаніші слова. І вчити починаємо саме з них. Щоб більш-менш говорити англійською мовою, достатньо півтори тисячі слів.

Ще одне пустощі: складати слова з букв випадковим чином, але враховуючи частоту появи, щоб було схоже на нормальні слова. У першій же десятці «випадкових» чотирилітерних слів вискочило «осел». У наступній півсотні - слова «мчимо» і «нато». Але, на жаль, дуже багато неблагозвучних комбінацій, таких як «блтт» або «нрро».

Тому – наступний крок. Я розбив всі слова на дволітерні поєднання і почав випадково (але з урахуванням частоти повторення) комбінувати їх. Стали у великій кількості вийдуть слова, схожі на «нормальні». Наприклад: «коївдіот», «воабма», «апий», «депоїд», «дебяко», «орфа», «поеснави», «озза», «ченя», «риторя», «урдеєд», «утоїчі», «Стих», «Сапоть», «Гравда», «Абабап», «Обарто», «Елує», «Лярези», «Мини», «бромомер» і навіть «тодебіст».

Куди застосувати є варіанти. Наприклад, написати генератор красивих фірмових грайливих імен. Для йогуртів. Типу, "мемолісо" або "уторорерто". Або - генератор футуристичних віршів «Бурлюк-php»: «опелдій міатон, ліноаз окміая... деесопен одесон».

І є ще один варіант. Треба спробувати...

Деякі статистичні дані про використання російських слів:

- Середня довжина слова 5.28 символ.

- Середня довжина речення 10.38 слів.

- 1000 найбільш частотних лем покриває 64.0708% тексту.

- 2000 найбільш частотних лем покривають 71.9521% тексту.

- 3000 найбільш частотних лем покривають 76.5104% тексту.

- 5000 найбільш частотних лем покривають 82.0604% тексту.

Після нотатки мені прийшов такий лист:

Здрастуйте, Дмитре!Проаналізувавши статтю «Мова до Києва доведе» та її частину, де Ви описуєте свою програму, виникла ідея.

Вами написаний скрипт здається мені призначеним абсолютно не для Поля чудес більшою мірою, а для іншого.

Перше найрозумніше застосування результатів роботи Вашого скрипта – визначення порядку букв при програмуванні кнопок для мобільних пристроїв. Так, так - саме в мобільних телефонах і потрібно все це.Я розподілив це по хвилях ()

Далі розподіл за кнопками:

1. Усі літери з першої хвилі йдуть на чотири кнопки в перший ряд

2. Всі літери з другої хвилі теж на решту 4 кнопок у той же перший ряд

3. Всі літери з третьої хвилі туди ж на дві кнопки, що залишилися.

4. 4,5 і 6 хвилі йдуть у другий ряд

5. 7,8,9 хвилі йдуть на третій ряд, причому 9-а хвиля йде вся повністю (не дивлячись на велику кількість букв) в третій ряд 9-ї кнопки, щоб 10 кнопку залишити під всякі там розділові знаки ( крапка, кома та інше).Я думаю, все зрозуміло і так, без детальних пояснень. Але все ж таки не могли б Ви обробити Вашим скриптом (включаючи знаки припинення) тексти наступного змісту:

А згодом викласти статистику? Мені здалося? що тексти максимально відображають нашу сучасну мову, а ми як говоримо, так і пишемо sms.

Заздалегідь велике спасибі.

Отже, аналізувати частоту повторення літер можна двома способами. Спосіб 1. Взяти текст, знайти в ньому унікальні (не повторювані) словоформи та аналізувати їх. Спосіб вдалий для побудови статистики за словами російської мови, а не за текстами. Спосіб 2. Не шукати в тексті унікальних слів, а відразу перейти до підрахунку частоти повторення літер. Отримуємо частоту букв у російському тексті, а чи не в російських словах. Для створення клавіатур та іншого потрібно використовувати саме цей спосіб: на клавіатурі набираються тексти.

Клавіатури повинні враховувати не тільки частоту літер, але й найзаповітніші слова (словоформи). Не так вже й важко здогадатися, які саме слова найуживаніші: це, по-перше, службовічастини мови, бо роль у них така - служити завжди і скрізь, і займенники, роль у яких не менш важлива: замінювати в мові будь-яку річ/людину (це вона, вона). Та й основні дієслова (бути, сказати). За результатами аналізу перерахованих вище текстів я отримав такі самі «популярні» слова: «і, не, в, що, він, я, на, с, вона, як, але, його, це, до, а, все, її, було, так, а, то, сказав, за, ти, о, у, йому, мені, тільки, по, мене, б, так, ви, від, був, коли, з, для, ще, тепер, вони, сказала, вже, його, ні, була, їй, бути, ну, ні, якщо, дуже, нічого, ось, себе, щоб, собі, цього, може того, до, ми, їх, чи, були, є, чим, або, ній» і так далі.

Повертаючись до клавіатур - очевидно, що в клавіатурі буквосполучення «не», «що», «він», «на» і інші повинні бути якомога ближче один до одного, або якщо не впритул, то якимось найбільш оптимальним чином. Потрібно провести дослідження, яким саме чином пальці рухаються по клавіатурі, знайти найзручніші позиції і помістити в них найуживаніші літери, не забуваючи, проте, для буквосполучення.

Проблема, як завжди, одна: навіть якщо й вийде створити Унікальну Клавіатуру, куди подіти мільйони людей, які вже звикли до qwerty/йцукен?

Щодо мобільних пристроїв... Напевно, it makes sense. Принаймні, літери «о», «а», «е» і «і» повинні бути точно на одній клавіші. Розділові знаки в порядку частоти вживання: , . -? ! ; :) (

Коротка постановка задачі

Є набір файлів з текстами російською мовою від художньої літератури різних жанрів до повідомлень новин. Потрібно зібрати статистику вживання прийменників з іншими частинами промови.

Важливі моменти у завданні

1. Серед прийменників є не лише уі до, але стійкі поєднання слів, що вживаються як прийменники, наприклад у порівнянні забо незважаючи на. Тому просто покришити тексти за пробілами не можна.

2. Текстів багато, кілька Гб, тому обробка повинна бути досить швидкою, принаймні, укладатися в кілька годин.

Малюнки рішення та результати

Враховуючи наявний досвід вирішення задач з обробкою текстів, вирішено дотримуватися модифікованого "unix-way", а саме - розбити обробку на кілька етапів, так щоб на кожному етапі в результаті виходив звичайний текст. На відміну від чистого unix-way, замість передачі текстової сировини через канали зберігатимемо все у вигляді дискових файлів. Добре вартість гігабайта на жорсткому диску нині мізерна.

Кожен етап реалізується як окрема, маленька і проста утилітка, що читає текстові файли та зберігає продукти своєї кремнієвої життєдіяльності.

Додатковий бонус такого підходу, крім простоти утиліт, полягає в інкрементальності рішення - можна налагодити перший етап, прогнати через нього всі гігабайти тексту, потім почати налагоджувати другий етап, не витрачаючи час на повторення першого.

Розбивка тексту на слова

Так як вихідні тексти, що підлягають обробці, вже зберігаються як плоскі файли в кодуванні utf-8, то нульовий етап - парсинг документів, висмикування їх текстового вмісту і збереження у вигляді простих текстовиків, пропускаємо, відразу переходячи до завдання токенізації.

Все було б просто і нудно, якби не той простий факт, що деякі приводи в російській складаються з декількох рядків, що розділяються пробілом, а іноді і комою. Щоб не розкрити такі багатослівні приводи, спочатку я залучив функцію токенізації в API словника. Макет на C# вийшов простий і нехитрий, буквально сотня рядків. Ось вихідник. Якщо відкинути вступну частину, завантаження словника та фінальну частину з його видаленням, все зводиться до пари десятків рядків.

Все це успішно перемелює файли, але на тестах виявився суттєвий недолік – дуже низька швидкість. На x64 платформі вийшло приблизно 0.5 Мб/хв. Звичайно, токенізатор враховує всілякі особливі випадки типу. А.С. Пушкін", Але для вирішення вихідного завдання така точність зайва.

Як орієнтир на можливу швидкість є утиліта статистичної обробки файлів Empirika. Вона робить частотну обробку 22 Гб текстів приблизно 2 години. Там усередині є і більш спритне вирішення проблеми багатослівних приводів, тому я додав новий сценарій, що включається опцією -tokenize у командному рядку. За результатами прогону вийшло приблизно 500 секунд на 900 Мб, тобто близько 1.6 Мб на секунду.

Результат роботи з цими 900 Мб тексту – файл приблизно такого ж розміру, 900 Мб. Кожне слово збережено на окремому рядку.

Частота вживання прийменників

Так як вбивати список прийменників у текст програми не хотілося, я знову-таки підчепив до C# проекту граматичний словник, за допомогою функції sol_ListEntries отримав повний список прийменників, близько 140 штук, ну а далі все тривіально. Текст програми на C#. Вона збирає лише пари прийменник+слово, але розширити проблем не складе.

Обробка 1 Гб текстового файлу зі словами займає лише кілька хвилин, у результаті виходить частотна таблиця, яку вивантажуємо на диск як текстовий файл. Прийменник, друге слово та число вжитків відокремлені в ньому символом табуляції:

ПРО РОЗбиті 3

ПРО ЗАБУТІ 1

ПРО ФОРМУ 1

ПРО НОРМУ 1

ПРО ГОЛОДУВАНИЙ 1

У ЗАКОННОМУ 9

З ТЕРРАСКИ 1

НЕГЛЯДЯ НА СТРІЧКУ 1

НАД ЯЩИКОМ 14

Усього з вихідних 900 Мб тексту вийшло приблизно 600 тисяч пар.

Аналіз та перегляд результатів

Таблицю з результатами зручно аналізувати у Excel чи Access. Я через звичку до SQL завантажив дані в Access.

Перше, що можна зробити - відсортувати результати в порядку зменшення частоти, щоб побачити найчастіші пари. Вихідний обсяг обробленого тексту занадто малий, тому вибірка не дуже репрезентативна і може відрізнятися від підсумкових результатів, але перша десятка:

У НАС 29193

У ТОМ 26070

У МЕНЕ 25843

ПРО ТОМ 24410

У НЬОГО 22768

ЦЬОГО 22502

У РАЙОНІ 20749

ПІД ЧАС 20545

ПРО ЦЕ 18761

З НИМ 18411

Тепер можна побудувати графік, так щоб частоти було по осі OY, а патерни вишикувалися вздовж OX за спаданням. Це дасть цілком очікуваний розподіл із довжелезним хвостом:

Навіщо потрібна ця статистика

Крім того, що дві утилітки на C# можуть використовуватися для демонстрації роботи з процедурним API, є ще важлива мета - дати перекладачу та алгоритму реконструкції тексту статистичну сировину. Крім пар слів ще будуть потрібні триграми, для цього треба буде трохи розширити другу зі згаданих утиліту.

- — Тематика захисту інформації EN word usage frequency … Довідник технічного перекладача

Ы; частоти; ж. 1. до Частий (1 зн.). Слідкувати за частотою повторення ходів. Необхідна год. посадки картоплі. Зверніть увагу на частоту пульсу. 2. Число повторень однакових рухів, коливань у яку л. одиницю часу. Ч. обертання колеса. Ч… Енциклопедичний словник

I Алкоголізм хронічний захворювання, що характеризується сукупністю психічних та соматичних розладів, що виникли внаслідок систематичного зловживання алкоголем. Найважливішими проявами А. х. є змінена витривалість до… Медична енциклопедія

ЗАХОПЛЕННЯ- один із специфічних термінів, що використовується в гакових записах русявий. безлінійного багатоголосся, що характеризується розвиненим підголосковим поліфонічним складом і різкою дисонантністю вертикалі. Співч. реалізація терміна в наст. час не вивчений… Православна енциклопедія

Стилостатистичний метод аналізу тексту- – це застосування інструментарію математичної статистики у сфері стилістики визначення типів функціонування мови у мові, закономірностей функціонування мови у різних сферах спілкування, типах текстів, специфіки функц. стилів та…

Порційний ароматизований снюс, міні порція Снюс вид тютюнового виробу. Являє собою подрібнений зволожений тютюн, який поміщають між верхньою (рідше нижньою) губою та яснами.

Науковий стиль- представляє наук. сферу спілкування та мовленнєвої діяльності, пов'язану з реалізацією науки як форми суспільної свідомості; відображає теоретичне мислення, що виступає в понятійно-логічній формі, для якого характерні об'єктивність і відволікання. Стилістичний енциклопедичний словник російської мови

- (У спеціалізованій літературі також патронім) частина родового імені, яка присвоюється дитині на ім'я батька. Варіації патронімічних імен можуть пов'язувати їх носіїв і з більш далекими предками дідами, прадідами.

Загальновживаність, застосовність, поширеність, застосовність, ходкість, загальноприйнятість Словник російських синонімів. споживання сущ., кіл у синонімів: 10 загальноприйнятість (11) … Словник синонімів

Міркування- – функціонально смисловий тип мови (див.) – (ФСТР), відповідний формі абстрактного мислення – висновку, що виконує особливе комунікативне завдання – надати мовленню аргументований характер (прийти логічним шляхом до нового судження або… … Стилістичний енциклопедичний словник російської мови